このブログは、株式会社フィックスターズのエンジニアが、あらゆるテーマについて自由に書いているブログです。

「実践的パフォーマンスエンジニアリングによるAI高速化×Data-centric AI入門」セミナー開催報告

2026年1月23日(金)に開催された、「【出版記念/オフライン開催】実践的パフォーマンスエンジニアリングによるAI高速化×Data-centric AI入門セミナー」のレポートをお届けします。

本セミナーは、技術評論社の「ML Systemsシリーズ」の新刊『実践的パフォーマンスエンジニアリングによるAI高速化』と、同シリーズの先輩書籍にあたる『Data-centric AI入門』の著者陣をお招きし、AI開発における「高品質なデータ」と「処理高速化」の両輪について深掘りするイベントとなりました。

当日の熱気あふれるセッションの模様をダイジェストでご紹介します。

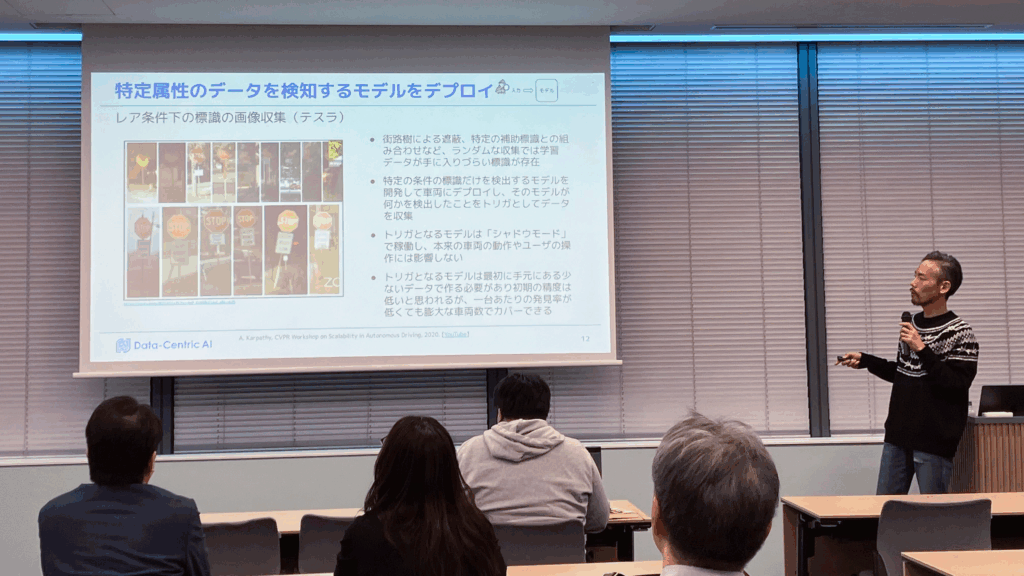

セッション1:AI開発をスケールさせるデータ中心の仕組みづくり

登壇者:宮澤 一之 氏(GOドライブ株式会社 / Data-Centric AI Community)

最初のセッションは、『Data-centric AI入門』の著者のおひとりであり、Data-Centric AIコミュニティを主催する宮澤氏による講演です。

宮澤氏はまず、従来のデータを固定してモデルを改善する「モデル中心(Model-centric)」な開発から、データを固定せずに改善し続ける「データ中心(Data-centric)」なAI開発へのパラダイムシフトについて解説しました。特に、テスラが提唱した「データエンジン(Data Engine)」の概念を挙げ、モデルが苦手とする状況のデータを重点的に収集し、再学習させてデプロイするサイクルの重要性を説きました。

講演の核となったのは、データエンジンを効率的に回すための「3S」というフレームワークです。

- Signal-to-noise(SN比)

- ただデータを集めるのではなく、モデルにとって有益なデータ(Signal)の比率を高めることが重要です。例えばテスラは、特定の標識条件など「モデルが苦手な状況」だけをトリガーにしてデータを収集しています。

- また、GOドライブ株式会社の事例として、地図情報(外部ソース)を活用してレアな標識がある場所を特定し、ピンポイントで動画を収集・アノテーションすることで効率を10倍改善した事例が紹介されました。

- Speed(速度)

- 当然ながら各プロセスの速度がデータエンジンの効率に直結します。特に、完全に人に依存したアノテーションはボトルネックになりやすいです。

- 開発中のモデルやLLMを活用してラベリングを半自動化する手法や、アノテーション時にのみ利用可能な知識を活用することで効率を大きく改善した事例などが紹介されました。

- Simplicity(単純性)

- 複雑なプロセスを排除し、スムーズにエンジンが回る仕組みを作ることです。

- LINEヤフーの「Data Quality as Code(品質要件をコードで管理)」の事例や、アノテーションチームとの密な連携・文化作りの重要性が語られました。

宮澤氏は最後に、「3Sを高めてデータエンジンを効率的に回し、データとモデルを共に成長させることが重要」と締めくくりました。

宮澤氏の講演資料は、SpeakerDeckで公開されていますので、ぜひご覧ください。

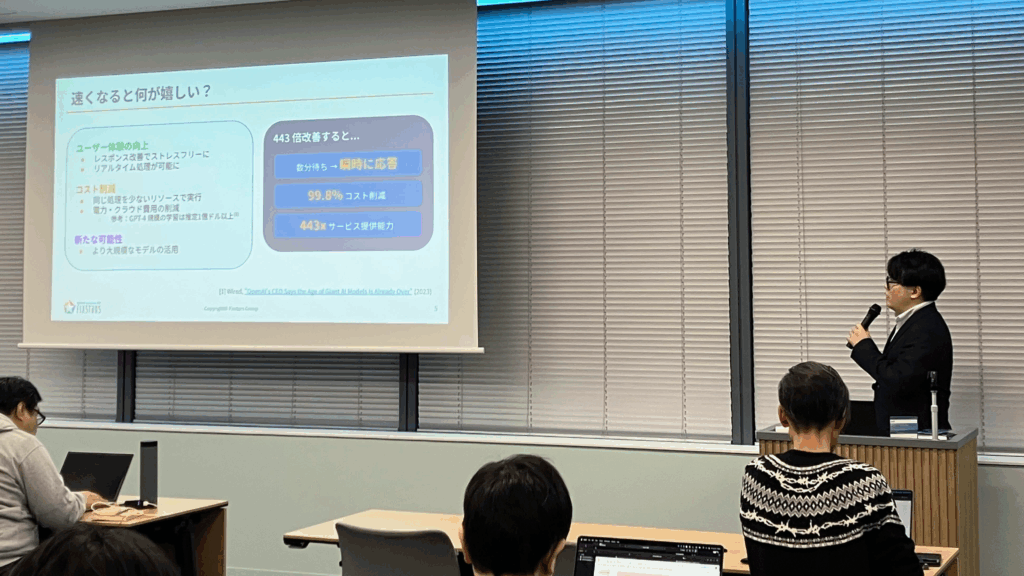

セッション2:実践的パフォーマンスエンジニアリングによるAI高速化

登壇者:寺西 勇裕(株式会社フィックスターズ)

続いて、『実践的パフォーマンスエンジニアリングによるAI高速化』の著者のひとりであるフィックスターズの寺西が登壇しました。

寺西は、AIの運用コストが高騰する中で、パフォーマンスエンジニアリングがビジネス価値(コスト削減・UX向上)に直結することを強調しました。例えば、443倍の高速化が実現できれば、計算上は99.8%のコスト削減と同義になります。

パフォーマンスエンジニアリングにおける鉄則として掲げたのが、「Don’t guess, measure.(推測するな、計測せよ)」という言葉です。

講演では、書籍内で扱われている具体的な高速化事例が紹介されました。

- LLM推論の高速化(443倍)

- Llama3 8Bモデルを用いた実験で、単に有名な高速化技術(FlashAttention-2)を適用しただけでは、逆に遅くなるケースがあることを計測により特定しました(バッチサイズが小さいとCPUネックになるため)。

- 計測に基づき、バッチサイズの拡大、vLLMの導入、FP8量子化などを段階的に組み合わせることで、最終的に443倍のスループット向上を達成しました。

- 自動運転AIの高速化

- LiDARの点群処理において、1点ずつ処理していた非効率な実装を計測で発見。GPUによる並列処理に変更することで、前処理時間を700msから15msへと大幅に短縮した事例が紹介されました。

寺西は、「勘に頼るのではなく、計測に基づいてボトルネックを特定し、適切な改善策を打つことで、AI投資の費用対効果を最大化できる」と、本書のメインメッセージをあらためて紹介しました。

特別ライトニングトーク & 懇親会

登壇者:吉藤 尚生 氏(Tenstorrent / 元フィックスターズ / 『実践的パフォーマンスエンジニアリングによるAI高速化』著者)

セミナーの最後には、元フィックスターズで、現在はTenstorrentで活躍されている吉藤氏によるライトニングトークが行われました。吉藤氏は、『実践的パフォーマンスエンジニアリングによるAI高速化』執筆時はフィックスターズに在籍しており、主要章の執筆を担当していました。

吉藤氏は、パフォーマンスエンジニアリングにおける「計測」の重要性に同意しつつ、現在の主流であるNVIDIA製GPUなどのハードウェアが「ブラックボックス」化しているという課題を提起しました。ドライバやハードウェアの内部挙動が公開されていないため、「なぜ遅いのか」の真因にたどり着けないもどかしさがあるとし、Tenstorrentが推進するRISC-Vベースのオープンアーキテクチャの重要性を熱く語りました。

セミナー終了後の懇親会では、登壇者と参加者が入り混じり、技術テーマはもちろん、執筆の裏話など、さまざまな話題で議論が交わされました。

おわりに

本セミナーでは、「データ」と「計算パフォーマンス」という、AI開発を成功させるための2つの重要な柱について、理論だけでなく現場の泥臭い実践知が共有されました。

多くの方にご参加いただき、誠にありがとうございました。

今回ご紹介した内容は書籍にて、より詳細に解説されています。ぜひお手に取ってご覧ください。

- 『Data-centric AI入門』(技術評論社)

- 『実践的パフォーマンスエンジニアリングによるAI高速化』(技術評論社)

また、フィックスターズでは、AI処理・ソフトウェア高速化に関するセミナーをたびたび開催しています。機会がありましたら、ぜひお気軽にご参加ください。

フィックスターズ イベント・セミナーのお知らせ: https://news.fixstars.com/category/event

Tags

Leave a Comment

Tags

Archives

- 2026年2月

- 2026年1月

- 2025年12月

- 2025年11月

- 2025年8月

- 2025年5月

- 2025年4月

- 2024年11月

- 2024年10月

- 2024年7月

- 2024年5月

- 2024年4月

- 2024年2月

- 2024年1月

- 2023年12月

- 2023年6月

- 2023年5月

- 2023年4月

- 2023年2月

- 2023年1月

- 2022年12月

- 2022年10月

- 2021年11月

- 2021年9月

- 2021年6月

- 2021年3月

- 2021年2月

- 2020年12月

- 2020年10月

- 2020年7月

- 2020年6月

- 2020年5月

- 2020年4月

- 2020年3月

- 2020年2月

- 2020年1月

- 2019年12月

- 2019年11月

- 2019年10月

- 2019年9月

- 2019年8月

- 2019年6月

- 2019年4月

- 2019年3月

- 2019年2月

- 2019年1月

- 2018年12月

- 2018年11月

- 2018年10月

- 2018年8月

- 2018年6月

- 2018年5月

- 2018年4月

- 2018年3月

- 2018年2月

- 2017年12月

- 2017年11月

- 2017年10月

- 2017年9月

- 2017年8月

- 2017年7月

- 2017年6月

- 2017年5月

- 2017年3月

- 2016年12月

- 2016年11月

- 2016年8月

- 2016年7月

- 2016年3月

- 2016年2月

- 2016年1月

- 2015年12月

- 2015年11月

- 2015年10月

- 2015年8月

- 2015年6月

- 2015年3月

- 2015年2月

- 2015年1月

- 2014年12月

- 2014年11月

keisuke.kimura in Livox Mid-360をROS1/ROS2で動かしてみた

Sorry for the delay in replying. I have done SLAM (FAST_LIO) with Livox MID360, but for various reasons I have not be...

Miya in ウエハースケールエンジン向けSimulated Annealingを複数タイルによる並列化で実装しました

作成されたプロファイラがとても良さそうです :) ぜひ詳細を書いていただきたいです!...

Deivaprakash in Livox Mid-360をROS1/ROS2で動かしてみた

Hey guys myself deiva from India currently i am working in this Livox MID360 and eager to knwo whether you have done the...

岩崎システム設計 岩崎 満 in Alveo U50で10G Ethernetを試してみる

仕事の都合で、検索を行い、御社サイトにたどりつきました。 内容は大変参考になりま�...

Prabuddhi Wariyapperuma in Livox Mid-360をROS1/ROS2で動かしてみた

This issue was sorted....